-

최소 제곱법practice_선형대수 2024. 9. 29. 12:29

최소 제곱법

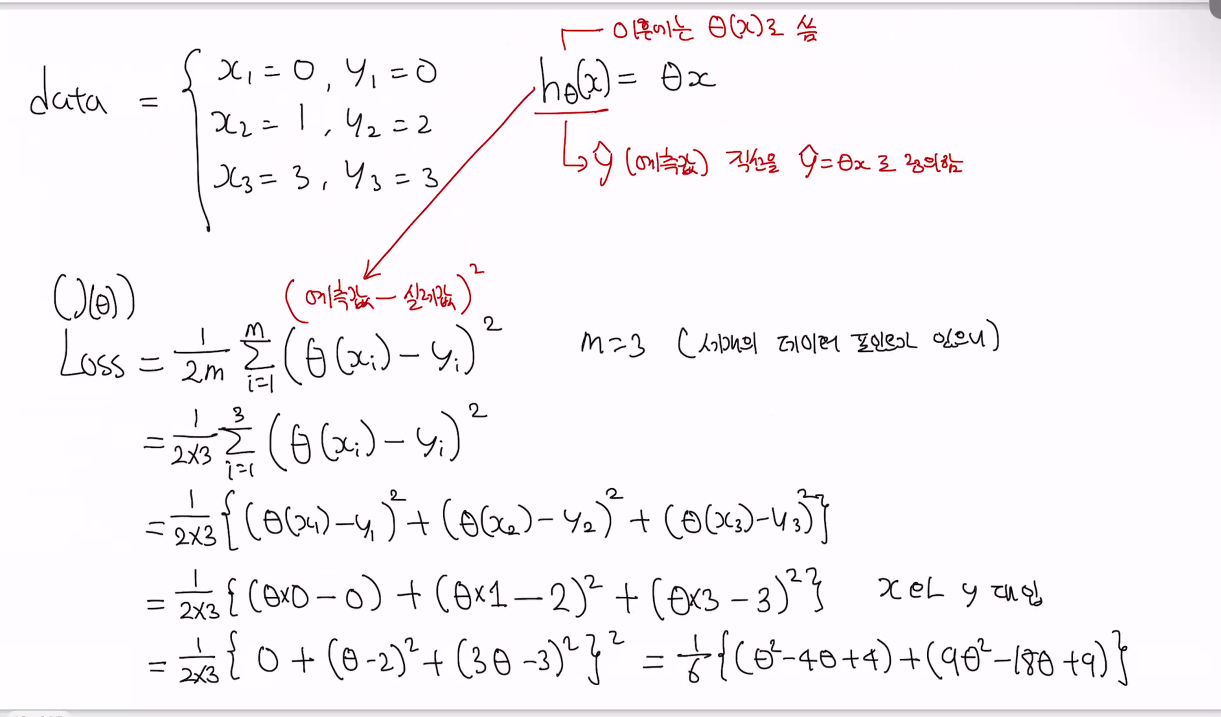

•선형 회귀에서 최소 제곱법(Least Squares Method=Mean square Error)의 개념과 목적을 설명해주세요.최소 제곱법은 데이터와 모델 예측값 간의 차이를 최소화하는 regression방법입니다.주어진 데이터 포인트와 모델의 예측값 간의 오차 제곱 합(의 평균) 을 최소화하여 가중치를 찾는다. 관련 개념:

관련 개념:

Residual (잔차): 실제 값과 모델 예측값 간의 차이입니다.

Loss Function (로스 함수): 예측값과 실제값차이의 제곱합을 나타내는 함수이다 (로스 함수를 최소화 하는것이 목적)

Normal Equation (정규 방정식): 최적의 파라미터를 구하기 위한 수식입니다.선형 회귀에서 "회귀"(regression)는 주어진 데이터로부터 변수들 간의 관계를 추정하는 과정을 의미해. 즉, 어떤 독립 변수(입력 값)와 종속 변수(결과 값) 사이의 관계를 찾는 것이지. '회귀'라는 용어는 변수가 평균으로 돌아가는 성질을 나타내기 위해 통계학자 프랜시스 골턴이 처음 사용했어. 그는 키와 같은 특성들이 세대를 거치면서 부모의 평균 키로 회귀하는 것을 관찰했고, 이를 회귀라고 불렀어.

특히 선형 회귀는 두 변수 사이의 관계가 직선(선형 함수)으로 표현될 수 있다는 가정하에, 독립 변수들이 종속 변수에 어떻게 영향을 미치는지를 모델링해. 예를 들어, 선형 회귀에서 목표는 최적의 직선을 찾아 **독립 변수(입력 데이터)**를 이용해 **종속 변수(결과 값)**를 예측하는 것이야. 이 직선의 방정식은 보통 아래와 같은 형태로 주어져:

y=wx+by = wx + b

여기서:

- yy: 종속 변수(결과 값)

- xx: 독립 변수(입력 값)

- ww: 독립 변수에 대한 가중치(기울기)

- bb: 절편

이러한 과정에서 모델은 데이터를 바탕으로 최적의 기울기 ww와 절편 bb를 찾는 거지. 그러니까, '회귀'는 데이터를 기반으로 이러한 관계를 찾고 미래의 값을 예측하는 과정이라고 이해하면 돼.

아래그림) 빨간직선이 평수에 따른 예상금액파란점이 실제데이터값

MSE: 차이의 제곱을 다 더해서 평균을 낸다 (절대값보다 제곱이 더 정확해서)

아래그림) h함수는 평수에 따른 예상금액 - 빨간직선

x(i)는 i번째 독립변수 (x축 파란 데이타값)

y(i)는 i번째 종속변수 (y축 데이터값(파란색 테이타의 왼쪽 집가격))

시그마 i부터 m까지 데이터값 모두더해서 1/m 해서 평균구함

학습 데이터의 개수를 보통 m

아래그림) h함수는 가설함수이고 θ를 통해서 파라미터이고 θ를 최적화해서 손실함수의 아웃풋을 최소화한다.

손실함수는 가설함수의 성능을 평가하는 함수

J( θ) 함수는 파라미터따라 loss값이 변수

θ에 따라 변하니까

'practice_선형대수' 카테고리의 다른 글

4.5.공분산(Covariance)과 상관계수(Correlation Coefficient)의 정의와 차이점 (0) 2024.09.29 03.확률 변수의 기대값(Expected Value)과 분산(Variance)의 정의와 관계 (0) 2024.09.29 1. 벡터공간과 성질 (0) 2024.09.28 미적분학 (0) 2024.09.05 선형대수 (0) 2024.09.04