-

출처: 패스트캠퍼스/ 딥러닝·인공지능 Signature 초격차 패키지 Online

•입력과 출력 간의 (선형)관계를 파악하는 것-> 처음 보는 입력에 대해서도 적합한 출력을 얻기 위함

•키와 몸무게의 (선형)관계를 파악해서-> 처음보는 키에 대해서도 적합한 몸무게를 출력하는 머신을 만들어보자

•“적절한” a, b 를 찾자뭐에 기반해서?

적절하다는 것은?

적절한 a, b 찾기

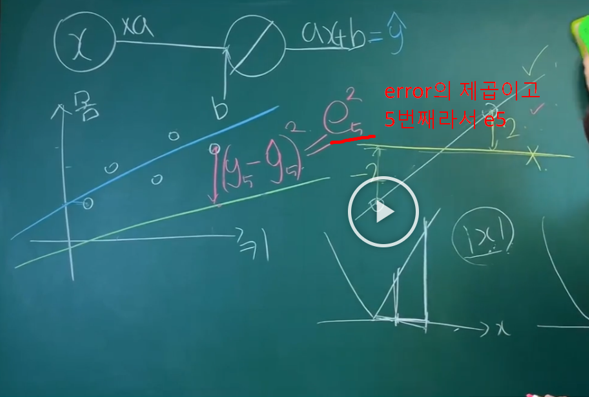

•loss (=cost)를 최소화 하는 a, b 가 바로 적절한 a, b!•머신의 출력(예측 y)̂ 과 나와야할 출력(정답)의 차이로 loss를 정의해보자•다양한 loss 함수 중 MSE (Mean squared error) 라는걸 쓴거다!•L을 최소화하는 a, b 어떻게 찾지?-> a, b를 일일 하 바꿔가며 L 값을 그래프로 그려보자

•좀더 스마트한 방법 없을까..?

MSN( min square error) MSN( min square error)

min square error

최소 제곱 에러!!!

(아래그림) mean squared error

평균 제곱 에러

argmin = argument 를 minimize

1/5 을 최소화하는 argmin( a, b값)

GRADIENT 반대방향을 수식표시

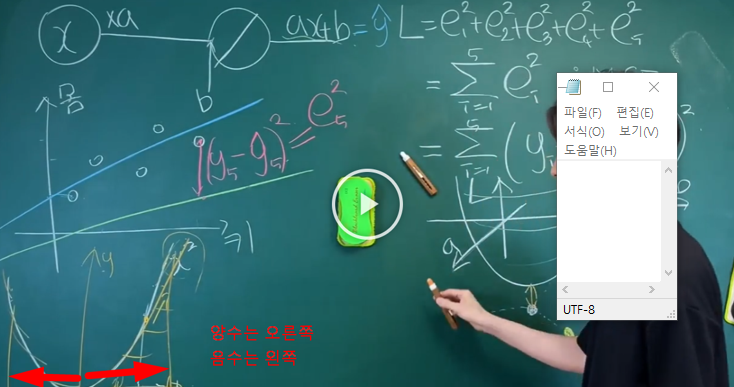

GRADIENT decent 반대방향으로 나아감

Gradient descent

•현재 a, b 위치에서 L을 줄이는 방향으로 나아가자•Gradient는 항상 가장 가파른 방향을 향한다..! (x2 으로 확인)왜 가장 가파른 방향? proof) 1-3강.

•그럼 그냥 반대 방향으로 가면 되겠네!•Learning rate (보폭) 의 존재 이유? <- 첨부터 끝까지 상수로 놓기도 하고 스케쥴링 하기도 함Initial weight? (LeCun, Xavier, He)

•1. 너무 신중하게 방향 선택..(모든 데이터 다 고려한 방향)2. local minimum

러닝 레이트

'인공 지능 개념' 카테고리의 다른 글

역전파 backpropagation (0) 2024.08.25 [요약] MSE & 선형회귀 Linear regression (0) 2024.07.31 [요약]인공신경망 요약 (0) 2024.07.31 neuron과 인공신경망 (0) 2024.07.30 선형회귀 _ Linear regression (0) 2024.07.30