-

[요약] MSE & 선형회귀 Linear regression인공 지능 개념 2024. 7. 31. 12:28

[머신 러닝] 선형 회귀(Linear Regression)

선형 회귀 집의 크기로 집의 값을 예측하는 경우를 생각해봅시다. 선형 회귀는 데이터에 가장 적절한 하나의 선을 찾아냅니다. 이 선을 최적선이라 합니다. 이 선을 통해 새로운 집의 크기에 대

velog.io

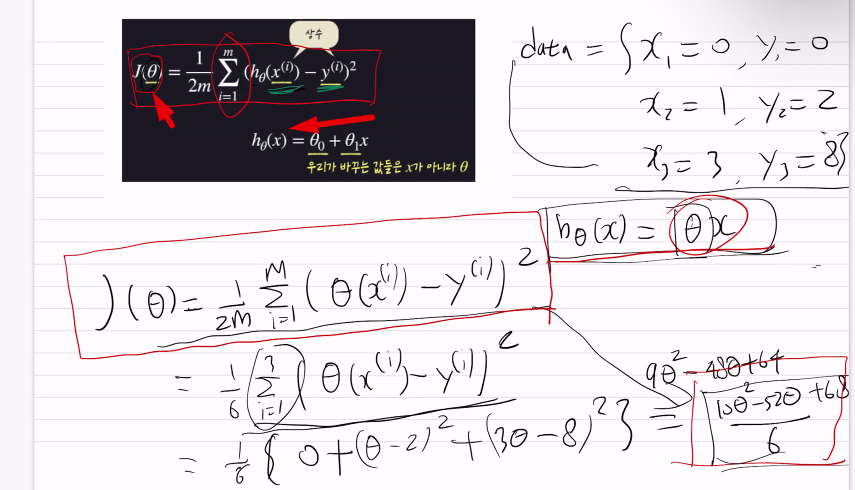

--> 이 식에 대해 설명해오기

경사하강법

loss함수(1차함수던지 2차함수인지)에서 경사하강법을 사용한다.

예) 당뇨일때 혈당가중치를 올려야 loss가 줄여짐

아래그림) 빨간직선이 평수에 따른 예상금액

파란점이 실제데이터값

MSE: 차이의 제곱을 다 더해서 평균을 낸다 (절대값보다 제곱이 더 정확해서)

아래그림) h함수는 평수에 따른 예상금액 - 빨간직선

x(i)는 i번째 독립변수 (x축 파란 데이타값)

y(i)는 i번째 종속변수 (y축 데이터값(파란색 테이타의 왼쪽 집가격))

시그마 i부터 m까지 데이터값 모두더해서 1/m 해서 평균구함

아래그림) h함수는 가설함수이고 θ를 통해서 파라미터이고 θ를 최적화해서 손실함수의 아웃풋을 최소화한다.

손실함수는 가설함수의 성능을 평가하는 함수

J( θ) 함수는 파라미터따라 loss값이 변수

θ에 따라 변하니까

경사하강법

다음 θ가 뭔지가 경사하강법

아래그림) 두 X 의 차이가 거의 가까워질때는

접선의 기울기가 미분

한점으로 수렴할때

경사하강법

학습을 통해서 파라미터를 변경해서 예측값을 변경해서 예측값과 실제값 차이를 줄이는방법

예측값과 실제값차이가 줄어들면 loss값이 줄어든다.

아래그림) 경사하강법

y = a(파라미터) * x(데이터 input, 입력값, 독립변수)

a = 0.4

y = 0.4 * x

검증방법 MES

x= 10 y= 0

y = 0.4 * 10 = 4

오차 = [ 6, -4, 10, -9]

오차의 절대값이 작아야함

절대값보다 제곱을 해서 마이너스를 없앤다.(절대값대신 - 나중에설명)

오차를 제곱해서 평균을냄Task: 문제 예시) 부동산 값

예측하는 모델이 필요

변수: 평수등 x, y

변수에 의해 부동산값이 달라짐

부동산 가격 = 평수 * a + b

1 * 1000만원 + b = 1000만원

1000만원 = 1평*a + b

3000만원 = 2평 *a + b

y = x평*a + b

종속변수 = y

독립변수 = x

파라미터 = a, b

딥러닝 개발자는 파라미터인 a, b를 최적화하는게 중요

activation function 정리해올것

러닝레이트 전까지 정리할것

a, b 가 파라미터

우리가 원하는 값을 구하기 위해 MSE (loss의 최소값) 을 구해서 최적의 a, b를 구하는것

1평 >> 1,000만원

2평 >> 3,000만원

4평 >> 4,000만원

5평 >> 6,000만원

...

y = a*x^2000 ,,,,

overfitting을 막기위해서

neural network

바늘에 찔렸을때 통증을 뇌에 100이 바늘이면 허벅지가 98 정도 숫자를 전달함

숫치가 높은것은 중요하다 여겨서 activation relu같은값으로 뇌에 전달

상대적으로 상관없는 코부분은 빠짐

이미지에서도 고양이같은 이미지에서 배경값은 고양이로 인식되지않는값은 빠짐

y = a(파라미터) * x(데이터 input, 입력값, 독립변수)

a = 0.4

y = 0.4 * x

검증방법 MES

x= 10 y= 0

y = 0.4 * 10 = 4

오차 = [ 6, -4, 10, -9]

오차의 절대값이 작아야함

절대값보다 제곱을 해서 마이너스를 없앤다.(절대값대신 - 나중에설명)

오차를 제곱해서 평균을냄'인공 지능 개념' 카테고리의 다른 글

로지스틱 Lost function (0) 2024.08.27 역전파 backpropagation (0) 2024.08.25 [요약]인공신경망 요약 (0) 2024.07.31 gradient (0) 2024.07.31 neuron과 인공신경망 (0) 2024.07.30