-

RNN (Recurrent Neural Network) 순환신경망인공 지능 개념 2024. 9. 9. 22:58

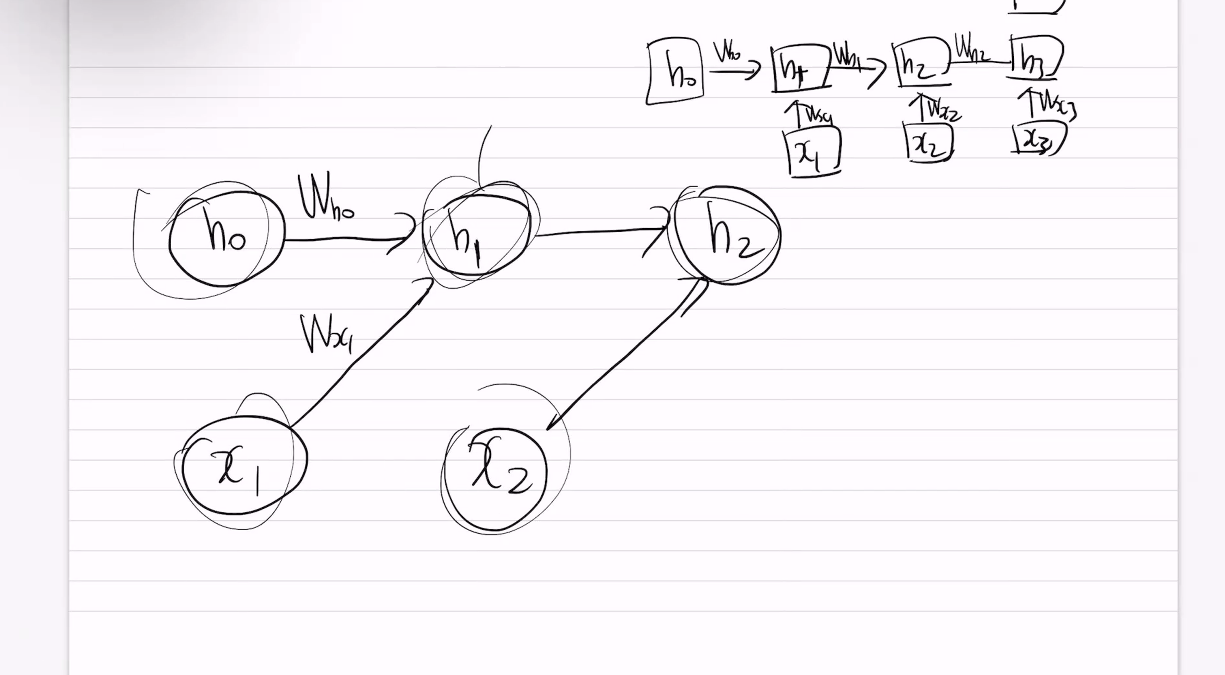

RNN = Sequence model (순서정보반영)

RNN - 연속적인 데이터

순서정보를 기억해서 순서대로 처리한다.

one to many

many to one

many to many ( 번역기)

================

바닐라 RNN 문제점 - 정보가 손실된다

장기 의존성 문제

순서대로 진행될때 맨앞에보다 나중에 갔을때 맨앞정보를 반영 못한다.

장기의존성

장기 의존성(Long-term dependencies)은 모델, 시스템 또는 알고리즘이 입력 시퀀스의 초반부에서 중요한 정보를 시간적 또는 맥락적으로 먼 거리까지 기억하고 활용하는 능력을 말합니다. 이는 여러 머신러닝 및 자연어 처리(NLP) 작업에서 매우 중요한 개념으로, 특히 문장이나 문서 내에서 멀리 떨어진 단어들이나 개념들 간의 관계를 이해하는 데 필요합니다.

NLP 및 순차적 데이터에서:

예를 들어, "창문을 깬 소년이 사과했다"라는 문장에서 "소년"이 사과했다는 것을 이해하려면 "소년"에 대한 정보를 "창문을 깬" 등의 여러 단어를 넘어 기억해야 합니다.

문제점:

전통적인 모델인 순환 신경망(RNN)은 관련된 정보들 간의 거리가 멀어질수록 그 정보를 유지하는 데 어려움을 겪습니다. 이 문제는 기울기 소실 문제(vanishing gradient problem)로 알려져 있으며, 이는 RNN이 많은 시간 단계를 거쳐 멀리 떨어진 입력 시퀀스의 중요한 정보를 전달하기 어렵게 만듭니다.

해결책:

- LSTM(Long Short-Term Memory) 및 GRU(Gated Recurrent Units): 이들은 게이팅 메커니즘을 사용해 정보의 흐름을 유지하고 제어할 수 있어, 더 긴 거리의 의존성을 효과적으로 처리할 수 있습니다.

- Transformer 모델: GPT나 BERT와 같은 모델들이 장기 의존성 처리 방식을 혁신적으로 바꾸었습니다. 이들은 어텐션 메커니즘을 사용해 시퀀스의 모든 부분 간의 의존성을 동시에 모델링할 수 있어, 입력을 순차적으로 처리하지 않고도 훨씬 더 긴 문맥을 효율적으로 처리할 수 있습니다.

- RNN -> LSTM(Long Short-Term Memory) 및 GRU(Gated Recurrent Units)-> 어텐션 메커니즘 -> Transformer

LSTM - RNN의 장기의존성(long term dependencies)의 문제점을 해결하기 위한 문제

방법- 삭제게이트, 입력게이트 이용해서 메모리셀을 만들고, 출력게이트와 메모리셀을 이용해서 히든스테이트를 만드는방법

메모리셀을 이용해서 히든스테이트를 만들었기 때문에 장기기억의존성 문제를 해결할수 있게됨

입력게이트 (i대한 입력게이트)

입력게이트 (g대한 입력게이트)

삭제게이트 (0과 1사이의 행렬)

셀상태 (Ct 새로운정보 만듬)

이전상태(Ct-1)의 메모리를 ft만큼 삭제 한후,

입력(it *gt)

tanh (새로운정보) -> gt 라고 하고,

it 는 시그모이드라서 0과 1의 확률값이라서

두개를 곱해서 it x gt

'인공 지능 개념' 카테고리의 다른 글

자료구조 - 그래프, 트리 (0) 2024.09.20 crossentropy (1) 2024.09.20 [아주중요]인공신경망- Chain Rule (0) 2024.09.08 CNN (0) 2024.09.07 Optimizer (0) 2024.09.07