-

1. 모멘텀(Momentum)

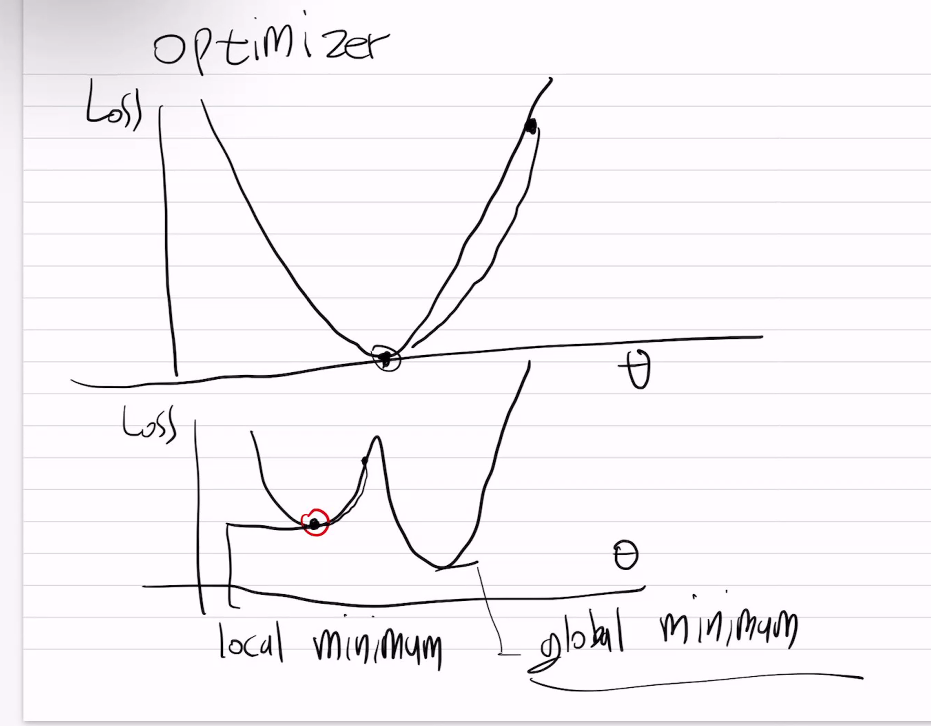

관성을 사용해서 local minimum을 극복한다.

tf.keras.optimizers.SGD(lr=0.01, momentum=0.9)

optimizer는 stochastic gradient descent

2. 아다 그라드(Adagrad)

변화가 많은 가중치의 러닝레이트를 올린다. 빠르게 학습시켜주기 위함

epsilon을 사용

3. 알엠에스프롭(RMS prop)

아다그라드는 시간이 지나면 학습률이 많이 낮아지는 문제점을 극복하기 위한법이 RMS prop

4. Adam

(RMSprop + 모멘텀)

'인공 지능 개념' 카테고리의 다른 글

CNN (0) 2024.09.07 Optimizer (0) 2024.09.07 순전파(Forward Propagation) (0) 2024.09.06 Perceptron (2) 2024.09.05 multi-class classification (0) 2024.09.03