•앙상블 학습(Ensemble Learning)의 기본 개념과 장점에 대해 설명해 주세요.

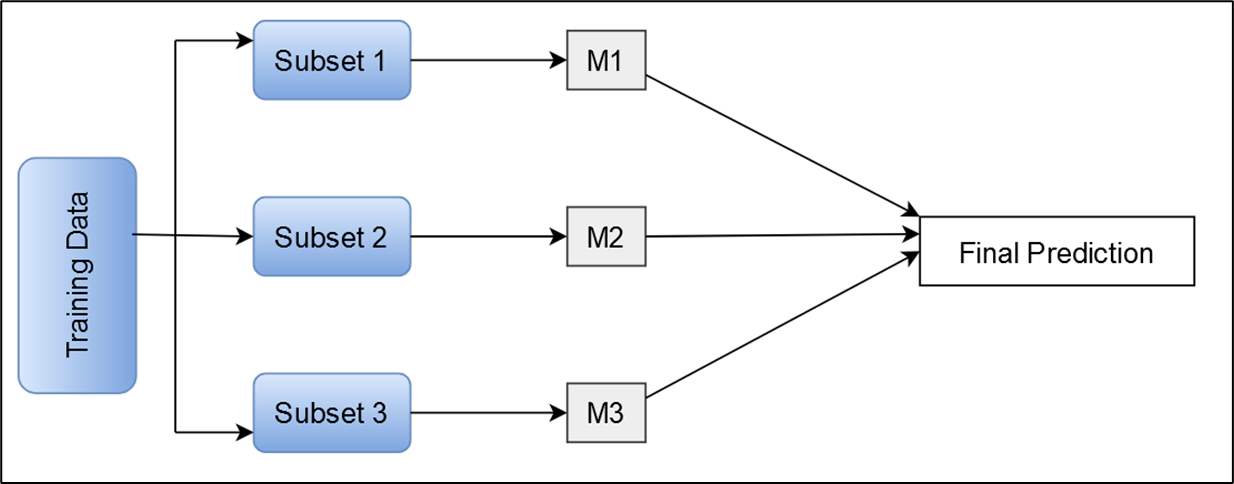

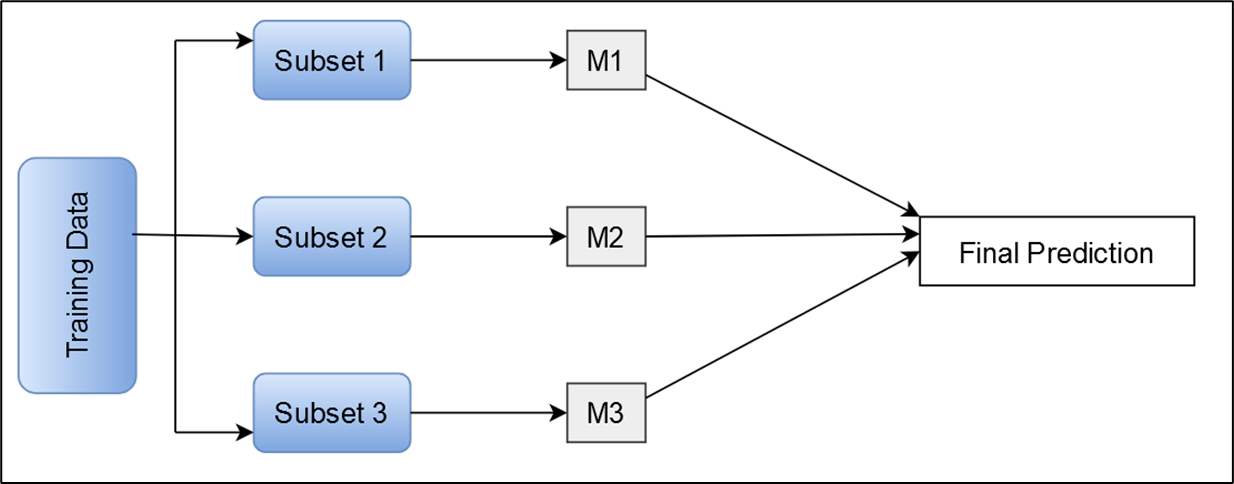

•앙상블 학습은 여러 개의 모델을 협합하여 최종 예측을 개선하는 방법입니다.

•주요 앙상블 기법으로는 배깅(Bagging)과 부스팅(Boosting)이 있으며, stacking 이 방법들은 모델의 예측 성능을 향상시키고 과적합(overfitting을 방지하는 데 도움을 줍니다.

•일반적으로 모델의 성능을 올릴려면 크기를 더 키우는 것이 효과적 (모델이 커지면 기억할수 있는 능력도 커짐)

•하지만 이 방법은 오버피팅의 위험성 또한 같이 증가시킴

•또다른 방법으로는 앙상블 학습이 있음

•상대적으로 단순한 모델들 여러 개가 협업해서 최종 예측을 만드는 것

•앙상블 학습에서는 각 모델이 주어진 데이터의 다양한 특징들을 독립적으로 학습함

•따라서 최종 예측은 보다 덜 편향적이고 일반화된 답을 할 수 있음 (오버피팅이 일어날 가능성이 상대적으로 적음)

•단순히 비유하자면, 여러 사람들이 서로 의견을 주고받으며 보다 나은 결론을 내는 상황과 비슷함

•Bagging

•여러 개의 독립적인 모델을 학습시키는 것

•Boosting

•여러 모델은 순차적으로 학습시키는 것

•각 모델은 이전 모델이 만든 실수를 교정함

•Stacking

•여러 모델의 예측을 사용해 새로운 메타 모델을 학습시키는 것

•메타 모델은 각 예측을 고려해 최종 예측을 만듬

•Boosting•여러 모델은 순차적으로 학습시키는 것•각 모델은 이전 모델이 만든 실수를 교정함

•Boosting•여러 모델은 순차적으로 학습시키는 것•각 모델은 이전 모델이 만든 실수를 교정함 •Stacking•여러 모델의 예측을 사용해 새로운 메타 모델을 학습시키는 것•메타 모델은 각 예측을 고려해 최종 예측을 만듬

•Stacking•여러 모델의 예측을 사용해 새로운 메타 모델을 학습시키는 것•메타 모델은 각 예측을 고려해 최종 예측을 만듬